Platform generasi baru Nvidia Blackwell akan datang ke Google Cloud pada awal 2025

Ini Google Cloud Next di Las Vegas minggu ini, dan itu berarti saatnya untuk sekelompok jenis instance dan akselerator baru yang akan muncul di Platform Google Cloud. Selain dari chip Axion berbasis Arm buatan khusus baru, kebanyakan pengumuman tahun ini adalah tentang akselerator AI, baik yang dibuat oleh Google atau dari Nvidia.

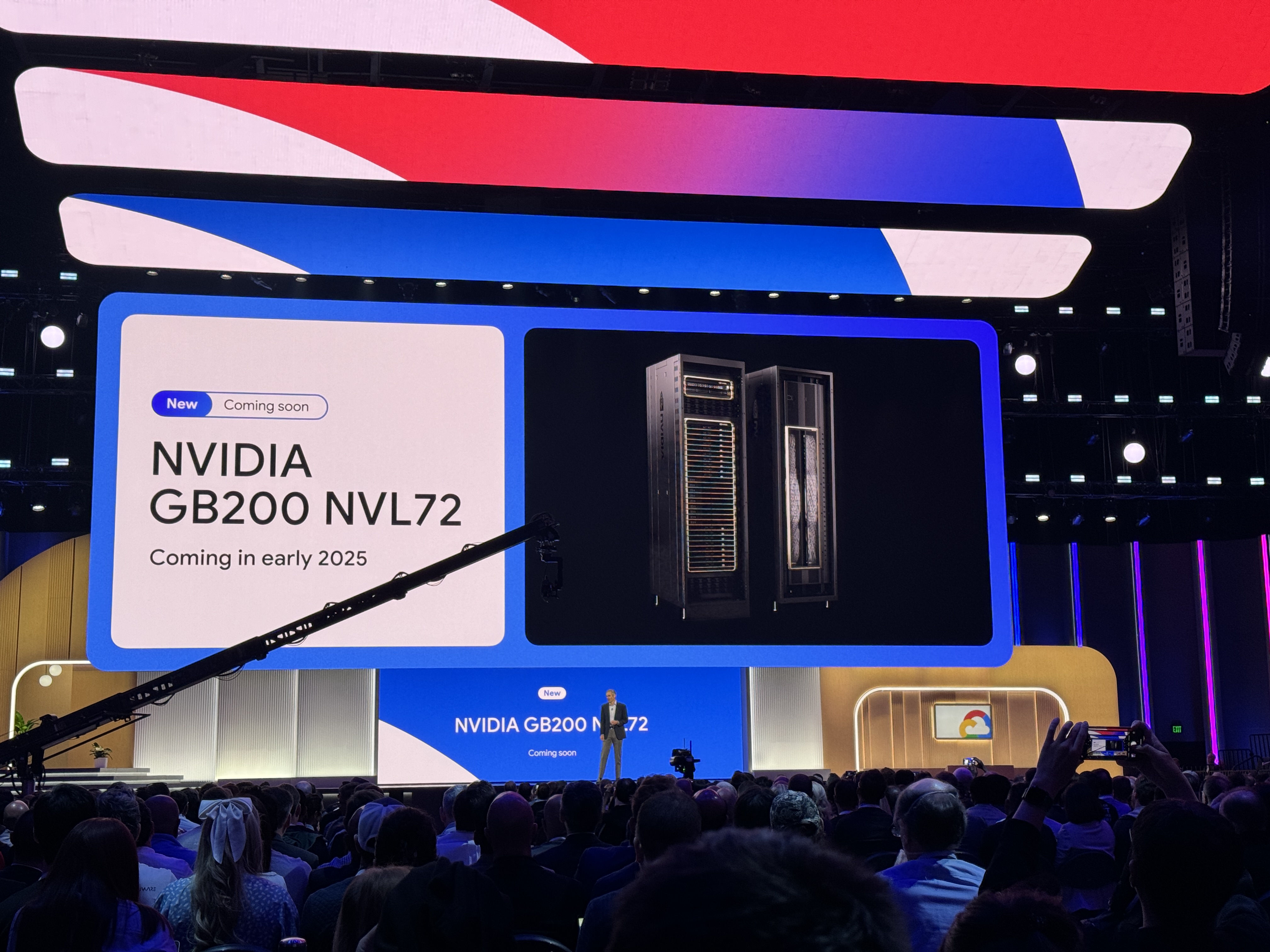

Hanya beberapa minggu yang lalu, Nvidia mengumumkan platform Blackwell-nya. Namun jangan harap Google akan menawarkan mesin-mesin tersebut dalam waktu dekat. Dukungan untuk Nvidia HGX B200 yang berkinerja tinggi untuk beban kerja AI dan HPC dan GB200 NBL72 untuk pelatihan model bahasa besar (LLM) akan tiba pada awal 2025. Satu hal menarik dari pengumuman Google: Server GB200 akan dilengkapi dengan pendingin cair.

Mungkin terdengar agak prematur, tetapi Nvidia mengatakan bahwa chip Blackwell nya tidak akan tersedia untuk publik hingga kuartal terakhir tahun ini.

Sebelum Blackwell

Bagi pengembang yang memerlukan kekuatan lebih untuk melatih LLM hari ini, Google juga mengumumkan instance A3 Mega. Instance ini, yang dikembangkan bersama Nvidia, menampilkan GPU H100 standar industri tetapi digabungkan dengan sistem jaringan baru yang dapat memberikan hingga dua kali bandwidth per GPU.

Instance A3 lainnya adalah A3 confidential, yang dijelaskan oleh Google sebagai memungkinkan pelanggan untuk “melindungi kerahasiaan dan integritas data sensitif serta beban kerja AI selama pelatihan dan inferensi dengan lebih baik.” Perusahaan telah lama menawarkan layanan komputasi rahasia yang mengenkripsi data saat digunakan, dan di sini, begitu diaktifkan, komputasi rahasia akan mengenkripsi transfer data antara CPU Intel dan GPU Nvidia H100 melalui PCIe yang dilindungi. Tidak diperlukan perubahan kode, kata Google.

Adapun chip milik Google sendiri, perusahaan pada hari Selasa meluncurkan prosesor Cloud TPU v5p-nya — akselerator AI buatan sendiri yang paling kuat hingga saat ini — ke ketersediaan umum. Chip ini menampilkan peningkatan 2x dalam operasi floating point per detik dan peningkatan 3x dalam kecepatan bandwidth memori.

Semua chip cepat itu membutuhkan arsitektur dasar yang dapat mengikuti mereka. Jadi selain dari chip-chip baru tersebut, Google juga mengumumkan pilihan penyimpanan teroptimalkan AI yang baru pada hari Selasa. Hyperdisk ML, yang kini dalam pratinjau, adalah layanan penyimpanan blok generasi berikutnya perusahaan yang dapat meningkatkan waktu pemuatan model hingga 3,7x, menurut Google.

Google Cloud juga meluncurkan sejumlah instance tradisional lainnya, didukung oleh prosesor Intel generasi keempat dan kelima Xeon. Instance umum baru C4 dan N4, misalnya, akan menampilkan Xeon Emerald Rapids generasi kelima, dengan C4 difokus pada kinerja dan N4 pada harga. Instance C4 baru sekarang dalam pratinjau pribadi, dan mesin N4 tersedia secara umum hari ini.

Juga baru, tetapi masih dalam pratinjau, adalah mesin bare-metal C3, didukung oleh Xeon Intel generasi keempat yang lebih lama, instance mata uang X4 yang dioptimalkan untuk memori (juga dalam pratinjau) dan Z3, mesin virtual yang dioptimalkan untuk penyimpanan pertama Google Cloud yang menjanjikan untuk menawarkan “IOPS tertinggi untuk instance yang dioptimalkan untuk penyimpanan di antara cloud terkemuka.”

Keynote Nvidia di GTC menghadirkan beberapa kejutan